芯東西9月19日報道,9月14日-15日,2023全球AI芯片峰會(GACS 2023)在深圳市南山區圓滿舉行。繼首日開幕式及AI芯片創新專場火熱開場(《云邊端AI芯片熱戰大模型!2023全球AI芯片峰會首日干貨》),峰會次日演講繼續輸出密集干貨滿載,在上午場的最后一個環節,2023中國AI芯片先鋒企業TOP30和2023中國AI芯片新銳企業TOP10評選結果正式公布。

▲2023中國AI芯片先鋒企業TOP30

▲2023中國AI芯片新銳企業TOP10

2023全球AI芯片峰會由智一科技旗下芯東西聯合智猩猩發起主辦,在南山區科技創新局的指導下以“AI大時代 逐鹿芯世界”為主題,設置七大板塊,主會場包括開幕式和AI芯片架構創新、AI大算力芯片和高能效AI芯片三大專場;分會場包括首次增設的集成電路政策交流會、AI芯片分析師論壇、智算中心算力與網絡高峰論壇。

在第二天的AI大算力芯片論壇、高能效AI芯片論壇上,上海交通大學計算機科學與工程系教授梁曉峣發表開場演講,隨后來自英特爾Habana、壁仞科技、千芯科技、Graphcore、中科加禾、芯和半導體、云天勵飛、知存科技、諾磊科技、邁特芯、肇觀電子、智芯科、原粒半導體、九天睿芯等15家頂尖AI芯片企業及新銳企業的創始人、技術決策者及高管分別發表主題演講,分享前沿研判與最新實踐。

通過峰會次日的嘉賓分享和觀點碰撞,我們看到大多數AI芯片企業都在積極備戰生成式AI與大模型浪潮帶來的時代機遇,嘉賓分享的議題焦點可以歸納為幾個關鍵詞:生成式AI、NVIDIA、GPGPU、落地挑戰、架構創新、存算一體。

無論是大算力AI芯片還是高能效AI芯片,都面臨存儲墻、功耗墻等共通的傳統架構痼疾,也正分別從核心應用場景的迫切之需出發,通過廣聯生態伙伴、優化軟硬協同,更大程度挖掘芯片性能的潛能,探索不依賴先進制程來實現性能提升、能效提升的新路徑、新解法。

大模型落地進程已經提速,但其與算力供應之間的差距目前沒有被彌合,國產大算力芯片正在通過不同的技術路徑發起沖鋒,提高芯片能效比的同時加速大模型落地。

1、GPGPU加速大模型訓練,用開源解決人、錢、時間難題

上海交通大學計算機科學與工程系教授梁曉峣談道,大家在AI大時代淘金,賣鏟子的NVIDIA“賺錢賺的最多”。他認為,包含CUDA Core和Tensor core(張量計算核心)的V100這代GPGPU,幫助NVIDIA奠定AI時代算力基座的行業地位。當谷歌、特斯拉等芯片公司拿出比NVIDIA更有效的矩陣計算方式后,NVIDIA為了鞏固自己在人工智能時代的霸主地位,在數制、稀疏性、互聯、內存帶寬等方面進行了多項革新。此外,NVIDIA構建的涵蓋編程語言、運行環境等完善的軟件生態是讓芯片好用的“護城河”。

芯片生態從軟件廠商圍繞核心芯片(架構)開發“領域專用軟件”發展到芯片廠商圍繞核心軟件(框架)開發“領域專用芯片”,直到現在芯片廠商和大模型公司圍繞核心應用開發“領域專用系統”。梁曉峣提到,當競爭對手領先時,可以用開源的方式解決資金、人才和時間的問題。開源也被證明是當對手特別強大時,較為有效的突圍方式。

去年,梁曉峣團隊推出自研開源GPGPU平臺“青花瓷”,支持大規模并行通用計算。梁曉峣解釋道,說的直接點就是除了游戲,希望NVIDIA的芯片能做的“青花瓷”都能做,同時還特別重視對NVIDIA GPGPU產品的兼容。他補充說,“青花瓷”平臺完全免費開放,這一平臺最主要目的是為行業提供GPGPU架構參考設計,開放給企業、高校進行基礎研究、實踐平臺、突破創新。

▲上海交通大學計算機科學與工程系教授梁曉峣

在產業界,壁仞科技也認同高性能GPGPU是訓練GPT大模型的關鍵。一方面,大模型在計算機體系結構中面臨計算、通信、存儲、并行擴展、穩定可靠五大挑戰;另一方面,還要解決用戶視角下,存得下、易擴展、易使用三大“溫飽”需求,以及高性能、低成本、低延時三大“小康”需求。

針對這些挑戰和需求,壁仞科技打造了面向大模型的軟硬一體全棧優化的解決方案,包括高性能集群、機器學習平臺suCloud、加速庫、訓練框架和推理引擎、超大模型框架、算法/應用六層架構。壁仞科技系統架構副總裁丁云帆談道,高性能通用GPU是訓練GPT大模型的關鍵算力基礎,互聯帶寬/拓撲是支撐GPT大模型分布式高效擴展的關鍵,基于自研BR104 GPU的主流量產產品壁勵104,壁仞科技可構建千卡GPU集群,并結合大模型分布式策略優化助力大模型創新落地。另外壁仞科技還與產業界的框架、模型伙伴、科研機構、高校等緊密合作打造大模型產學研用生態。

▲壁仞科技系統架構副總裁丁云帆

2、傳統架構難突破帶寬、成本瓶頸,大模型時代亟需超越GPU新架構

“大模型本質是對知識的壓縮和對輸入的反饋,即存算一體、以存代算。”千芯科技董事長陳巍談道,“LLM/MLM的開源資源、部署訓練架構、算力成本成為大模型應用落地和企業盈虧的關鍵分水嶺。”

陳巍介紹了幾種典型的商用大模型存算一體架構落地情況,并指出”特斯拉的Dojo芯片使用了近存計算架構優化數據通道,或是為大模型量身定制“,”微軟三星等科技巨頭正在投資存算一體芯片企業“。

Habana中國區負責人于明揚一上臺便放話:演講不摻廣告,都是真實體驗。“我們認為,每個Billion(十億)的參數規模,在有限時間范圍內要把訓練做好,基本需要的算力大概在16卡。”

他談到大模型給硬件層帶來壓力,對單卡的算力、內存、服務器互聯方案、集群長時間穩定運行等提出更高要求。在大模型發展過程中,上層框架及軟件生態扮演的角色越來越重要。傳統模型很大程度需要CUDA的資源進行訓練,但大模型時代更多強調高層框架軟件生態——如何解決集群管理與穩定性、訓練過程中的并行化要求等。

于明揚總結了面向大模型高效訓練和推理的一些選擇,包括計算速度、高速存儲、高擴展性、易用性、高能效、高性價比。在大模型時代,企業如果能很好地針對框架做優化,有機會繞開CUDA生態墻,打破NVIDIA在市場上一家獨大的局面。

▲Habana中國區負責人于明揚

GPU、CPU之外,英國芯片公司Graphcore(擬未科技)提出了IPU架構,支持FP8浮點運算,基于此來應對對話式AI的時延、應用成本與能耗的挑戰。早在2018年,AI教父Geoff Hinton就看到了IPU架構的潛力,他在接受采訪時以Graphcore的IPU芯片為例,大力倡導為構建功能更像大腦的機器學習系統轉向不同類型的計算機。

Graphcore中國區產品總負責人朱江提到,IPU采用了大規模并行的多指令多數據架構,并極大地擴展了片上SRAM的大小,使得片內存儲吞吐量達到65TB/s。這樣大規模的片上存儲和分布式設計,可以極大地提高訪存帶寬和內存訪問效率,有力地幫助客戶打破內存墻的瓶頸。IPU的獨特設計還使其實現了高效的訪存能耗。同樣是搬運一個byte的數據,CPU大概需要消耗320pJ,GPU大概需要64pJ,而IPU大概需要1pJ。此外,Graphcore推出的Bow IPU還采用了WoW的先進封裝,并在支持數據類型上進行了投入,成為業內最早支持FP8精度的硬件之一。

▲Graphcore中國區產品總負責人朱江

3、產業鏈創新:編譯器+EDA平臺,提高AI芯片適配性

大模型應用與算力之間的差距,加速了企業在兩者間構建“橋梁”,縮小其中差距的步伐。

中科加禾創始人崔慧敏認為,大模型讓國產AI芯片面臨的生態困境更加凸顯,編譯器成為一大破解之道。簡單來說,編譯器是用于將機器語言翻譯為人類語言的工具,在AI芯片產業鏈中,相當于AI芯片與AI用戶之間的“橋梁”。

在GPU時代,編譯器大家主要使用的是NVIDIA的CUDA編譯器。隨著AI時代到來,編譯器的內涵和外延進一步擴大,涉及了圖、張量、指令、圖算融合等不同層面的編譯。

大模型時代,編譯器能夠促進芯片性能提升、跨平臺優化及安全性增強。崔慧敏談道,在性能方面,編譯技術可以發掘更激進的融合策略,進一步全局對計算、同步進行重排優化,為模型推理側帶來最高2~3倍的性能提升;在跨平臺方面,中科加禾認為基于機器模型可以有效支撐編譯優化的跨平臺表現;在安全方面,編譯技術能以很低的開銷來實現軟件TEE,增強安全性。

目前,中科加禾正聚焦搭建對不同芯片都適用的工具集,通過組件化服務助力AI芯片完成生態遷移等目標,并計劃在2023年12月推出跨平臺大模型推理引擎。

▲中科加禾創始人崔慧敏

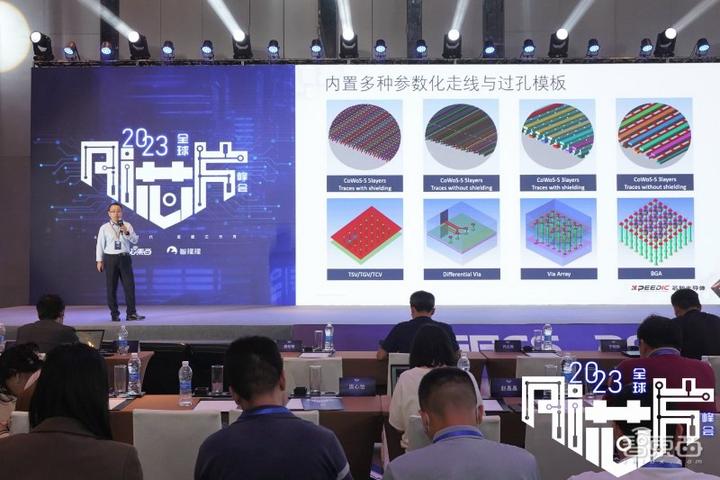

單芯片SoC向新型“SoC”(System of Chiplets)架構演進過程中,芯和半導體產品應用總監蘇周祥談道,Chiplet對單顆SoC的拆分、組合和架構規劃問題,給傳統的設計流程帶來了很大的挑戰。

他認為,Chiplet從系統最初的設計到最終的嵌合簽核,都需要新的工具、新的思路和新的方法學。芯和半導體給出的答案是一個圍繞Chiplet產業的全新EDA平臺,蘇周祥說道,全新平臺需要支持系統級連接、堆棧管理、層次化設計,還需要在物理實現方面協同設計環境、支持各領域的工具、多芯片3D布局規劃和布線。

因此,芯和半導體推出專為3DIC Chiplet量身定做的仿真全流程EDA平臺,這是一個針對Chiplet的完整的包括設計、SI/PI/多物理場分析的解決方案。該平臺擁有AI驅動的網格剖分技術,以及云計算加載的分布式并行計算能力,還支持裸芯片、中介層和基板的聯合仿真引擎技術。

▲芯和半導體產品應用總監蘇周祥

大模型強大的內容生成、理解能力,使得其在云邊端的多類型應用場景出現,不同場景為高能效AI芯片提出了新要求。邊緣AI芯片對低功耗、高性能的需求增長;大模型對容量和帶寬既要又要,存算一體芯片的存儲介質如何選擇。

這一背景下,高能效AI芯片的發展呈現出三大趨勢,分別是為大模型構建低功耗AI網絡,通過存內計算突破功耗墻和存儲墻問題,以及邊緣端的智能視覺處理芯片需求增長。

1、算力方案構建低功耗AI網絡,大小模型或在云邊端協同進化

智芯科聯合創始人&CEO顧渝驄談道,大模型發展會面臨兩方面瓶頸,大數據和大模型所產生的顯存墻問題(模型是否能跑起來)以及計算墻(能否在合理時間內完成推理)問題。他認為,存內計算是解決這兩大難題的有效解法,相比于GPU能更有效地利用數據,降低功耗;更高效地讀取寫入數據;集成存儲和計算,提供更大內存容量。智芯科計劃基于精度無損SRAM的存內計算CIM推出針對大模型的900系列芯片,有望替代NVIDIA在專有云、推理側的應用。

大模型帶來的算力爆發遠超摩爾定律,同時大功耗算力設施帶來的碳排放量巨大,因此,邁特芯希望做一款低功耗芯片,把功耗降下來。邁特芯基于立方脈動并行架構的存算芯片來滿足大模型部署。邁特芯創始人兼CEO黃瀚韜談道,通過用更低的bit來表示GPT-3的主要數據,可以將大模型參數規模變小,邁特芯可在ChatGLM2-6B大模型上用INT4和INT2算力,達到跟ChatGLM2-6BFP16相當的推理水平。在架構方面,邁特芯針對大模型算法搭建立方單元架構,通過立方脈動陣列實現高強度并行計算,其解決方案能兼顧高通量和低功耗。

▲邁特芯創始人兼CEO黃瀚韜

在原粒半導體聯合創始人原鋼看來,隨著大模型蒸餾技術發展,超大模型可以生成一系列適合邊端的小模型,取得接近于大模型的效果。原粒半導體基于AI Chiplet把SoC算力跟NPU(神經網絡處理器)的AI算力解綁,再靈活組合出邊緣端芯片,以適配邊緣端大模型的推理要求。目前,原粒半導體已研發出多模態算力核心CalCore技術,支持企業將大模型部署在端側;以及自適應算力融合CalFusion技術,自動分配芯粒以捆綁不同的算力。

▲原粒半導體聯合創始人原鋼

全球邊緣計算市場規模不斷擴大,但因場景、芯片平臺、算力需求碎片化等痛點使得其算法投入產出往往不成正比,這有望依托于大模型強大的圖像、語言理解、場景泛化能力得到突破。同時,云天勵飛副總裁、芯片業務線總經理李愛軍提到,邊緣計算芯片設計需要考慮SoC集成、算力可靈活擴展芯片架構、統一的工具鏈架構、隱私保護等方面因素。云天勵飛基于其自研算法開發平臺和算法芯片化平臺,訓練了“云天書”大模型,推出內置云天勵飛第四代神經網絡處理器的新一代邊緣計算芯片DeepEdge10,能滿足大模型部署需要。

▲云天勵飛副總裁、芯片業務線總經理李愛軍

2、多存儲介質方案迸發,存算一體突破功耗、存儲瓶頸

當前大模型對容量和帶寬既要又要,存算一體芯片正處于多種存儲介質百花齊放的格局。

千芯科技將不同類型存儲器融合到統一存算架構(UMCA),可為客戶的應用場景提供SRAM、Flash、RRAM多種存算芯片方案;通過多處理器融合,使存算一體保持大算力高能效,同步獲得CPU、GPGPU的通用生態能力。其存算一體架構不依賴先進工藝,可基于成熟工藝達到先進算力;并提供芯片級算法壓縮技術,方便大模型客戶無感使用量化剪枝稀疏等壓縮技術來達到降本增效的目標。

▲千芯科技董事長陳巍

智芯科聚焦的是SRAM,智芯科聯合創始人&CEO顧渝驄提到,他們將推出針對大模型的900系列,該系列可以提供1000-2000TOPS的算力,為邊緣側大模型推理提供算力,功耗為150W,采用12nm制程,價格遠低于NVIDIA。

此外還有推出基于SRAM純數字及模數混合架構的多重融合存內計算技術的九天睿芯。九天睿芯副總裁袁野談道,AIGC在內容生成之外,還帶來AR/VR、具身智能、外部感知信號鏈等的全面升級,其采用的混合架構模式,能實現有效精度計算,CIMD(純數字存內計算)+CIMX(模數混合純內計算)兩種存算架構在芯片方面融合,能支持訓練+推理一體應用,并使性能最大化。此外,存內計算可以通過互聯、疊加實現更大算力,九天睿芯已積累多個智能信號鏈(智能感知/互聯)的基礎IP,并啟動告訴互聯接口技術研發,為實現大算力做準備。

▲九天睿芯副總裁袁野

在知存科技業務拓展副總裁詹慕航看來,AI神經網絡或者CNN矩陣運算、卷積運算的核心就是矩陣乘法/乘加運算,越典型的大模型越需要矩陣運算,便越適合存內計算的方式,將“存”和“算”結合,一次性并行完成。因此,知存科技選擇使用Flash存儲器完成AI神經網絡的儲存和運算,以解決存儲墻問題。

知存科技推出的WTM-2端側AI芯片,具備極低功耗、極低延遲,其已量產的國際首顆存內計算芯片WTM2101功耗僅5uA-3mA,兼具高算力,適用端側智能物聯網場景。下一步,知存科技還將針對視頻增強場景推出WTM-8系列芯片,該系列芯片具備4核存算MPU,單核提升算力80倍,提升效率10倍。

▲知存科技業務拓展副總裁詹慕航

3、3D視覺應用滲透加速,創新方案1個大腦指揮8只眼睛

肇觀電子CEO馮歆鵬認為,隨著視覺技術從2D向3D發展,智能3D視覺應用將滲透到全行業,且路線圖可以往五十年以后延伸。但硬件成像限制和AI感知局限是3D視覺行業繞不開的痛點,馮歆鵬談道,為了解決上述問題,肇觀電子積累了3D、VSLAM、AI和OCR光學字符識別等多項機器視覺核心技術。其中,肇觀電子3D深度相機能適用冷庫機器人在-18℃的環境里啟動“眼睛”完成任務等極限場景,他還提到,部分海外巨頭的機器視覺技術甚至無法在低溫環境里開機。

▲肇觀電子CEO馮歆鵬

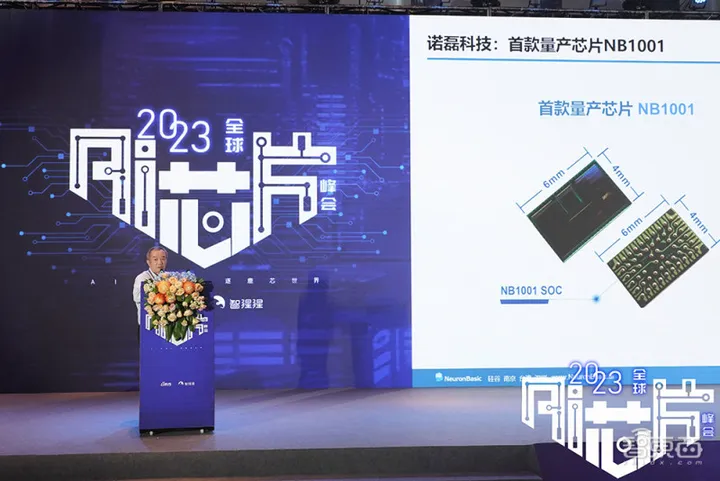

諾磊科技推出的集成CIS+AI+MCU光譜識別功能的感算一體AI光譜分析芯片陣列技術“Eye with Brain”,能做到“1個眼睛照顧8個大腦”,還能實現對多頻段光譜的檢測與分析。有別于AI業界的傳統算法,諾磊科技的產品配合高度集成機器影像辨識傳感器,能獨立運行實現影像偵測、追蹤及識別。諾磊科技創始人、CEO Raymond Wu提到,諾磊科技在首款110nm工藝量產芯片NB1001上,結合WLO(晶圓級光學)技術,將光學元件集成到半導體晶圓上,設計為類似于麥克風陣列的光譜檢測陣列。

Raymond Wu還提到,曾經一枝獨秀的影像解決方案CCD由于系統體積大、成本高、功耗大、落地難逐漸被CIS(CMOS圖像傳感器)取代。這與當下AI應用有相似性,他認為高算力并不是能百分之百解決所有AI應用的手段,AI應用的算力需求取決于具體應用的場景,單一化應用沒有必要做復雜的AI芯片。

▲諾磊科技創始人、CEO Raymond Wu

2023全球AI芯片峰會第二天,云邊端AI芯片熱戰大模型的戰況更盛。

一方面,面向大模型的海量算力需求,國產大算力芯片廠商已經發起技術沖鋒。GPGPU廠商從芯片設計、解決方案和生態多方面加快大模型場景落地,國內外的AI芯片廠商試圖用創新架構打破NVIDIA一家獨大局面,此外上下游產業鏈也在通過編譯器、EDA等技術的創新為AI芯片性能提供“放大器”。

另一方面,大模型的落地場景正從云端延伸至邊緣側、端側,使得國內一批高能效AI芯片廠商看到了市場發展機遇。通過存內計算、立方單元架構、Chiplet等不同創新架構,AI芯片廠商不約而同地探索降低AI芯片能耗和算力成本的最短路徑,從而為大模型的規模化落地提供條件。隨著大模型在端側、邊緣側的部署門檻降低,大小模型有望實現更好的協同,從而促進AI落地產業的深度和廣度大大加強。

通過第二天的峰會,我們可以看到以下五大產業發展趨勢值得關注:

1、作為首屈一指的芯片巨頭,NVIDIA通過在數值、稀疏性、互聯、內存帶寬等方面的革新,鞏固了其在AI時代的霸主地位。對此,國內GPGPU廠商可以通過開源的方式解決錢、人、時間的問題。

2、傳統架構難以突破大模型訓練中的帶寬和成本瓶頸,市場需要超過NVIDIA GPU的新架構。存內計算/邏輯能讓芯片能效大幅提高,突破功耗墻和存儲墻問題,從而以成熟工藝突圍大算力芯片。

3、面向大模型場景,AI芯片廠商需要滿足存得下、易擴展、易使用三大溫飽需求,以及易使用、低成本、低延時三大升級需求。這需要AI芯片廠商加快技術架構創新,也需要用軟硬一體化解決方案去突破。

4、大模型讓國產AI芯片面臨的生態困境更加凸顯,需要產業鏈上下游加快適配。比如通過編譯器創新,產業能夠促進芯片性能提升、跨平臺優化及安全性增強;也有企業打造圍繞Chiplet產業的全新EDA平臺,為芯片設計創新提供支持。

5、大模型正從云端場景向邊緣側、終端延展。在邊緣側和終端場景,客戶對AI芯片的能耗和成本更加敏感。為此,AI芯片領域的玩家通過存內計算、立體單元架構、模型稀疏化、Chiplet等路徑降低芯片能耗和成本,支持大模型“下沉”。

結合前后兩天的2023全球AI芯片峰會產學研投領域46+位大佬的交鋒,我們發現,“得算力者得天下”已經成為大模型時代的特征,跳出NVIDIA GPU路徑的新架構、新產品越來越多。隨著摩爾定律逼近極限,現實算力資源與理想算力資源之間存在巨大鴻溝,在NVIDIA之外,市場上已經涌現出更多能夠填補市場空白的AI芯片企業,推動市場呈現“百花齊放”態勢。

從2018年舉辦第一屆開始發展到今天,全球AI芯片峰會至今已連續舉辦五屆,峰會目前已經觸達到了AI芯片產業鏈的設計、EDA、編譯器等多個核心重要環節,覆蓋云邊端等全場景的芯片巨頭和新銳創企,以及來自學術圈和投資界的專業人士。在過去兩天的峰會中,我們聽到了頂級AI芯片產學研用及投融資領域專家們的思想交鋒,多元的精彩觀點在這里碰撞。乘風新技術浪潮,全球AI芯片峰會已經成為國內極少數專注在AI芯片領域且具有較大影響力的行業峰會。